引言

随着大数据时代的到来,数据量呈爆炸式增长,如何高效地对海量数据进行处理和分析成为了一个关键问题。数据切片技术作为一种重要的数据处理手段,能够将大数据集分割成小块,便于后续的存储、分析和处理。本文将探讨高效数据切片算法,分析其原理、应用场景以及实现方法。

数据切片算法的原理

数据切片算法的核心思想是将原始数据集按照一定的规则进行分割,形成多个较小的数据块,这些数据块通常被称为“切片”。每个切片包含原始数据集的一部分,但保留了数据集的整体结构。以下是几种常见的数据切片算法原理:

基于哈希的切片:通过哈希函数将数据集中的每个记录映射到一个唯一的哈希值,然后根据哈希值将数据分割成多个切片。

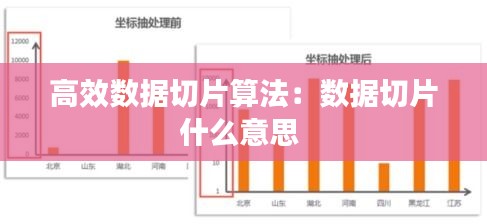

基于范围的切片:按照数据集中的某个字段(如时间戳、ID等)的值将数据分割成多个切片。

基于索引的切片:根据数据集中的索引信息将数据分割成多个切片。

高效数据切片算法的设计

为了实现高效的数据切片,算法设计需要考虑以下几个方面:

切片粒度:切片粒度是指每个切片的大小。合适的切片粒度可以平衡内存使用和数据处理的效率。

切片分配策略:切片分配策略决定了如何将数据分割成多个切片,以及如何分配这些切片到不同的处理节点。

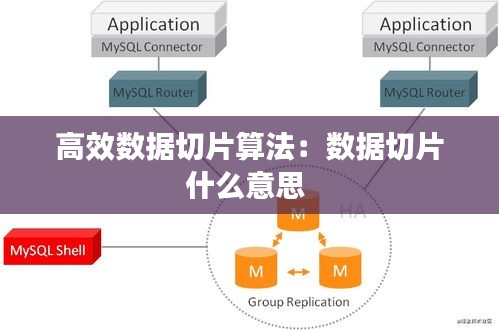

并行处理:通过并行处理技术,可以将数据切片分配到多个处理器或计算节点上,提高数据处理速度。

负载均衡:在数据切片过程中,需要考虑如何实现负载均衡,确保每个处理节点的工作负载均匀。

常见高效数据切片算法

以下是一些常见的高效数据切片算法及其特点:

MapReduce切片算法:MapReduce框架中的数据切片算法通过将数据集分割成多个Map任务,然后在Reduce阶段进行合并,实现高效的数据处理。

Spark切片算法:Spark框架中的切片算法通过将数据集分割成多个RDD(弹性分布式数据集),支持高效的分布式数据处理。

基于索引的切片算法:通过索引信息将数据集分割成多个切片,适用于需要频繁查询的场景。

数据切片算法的应用场景

数据切片算法在以下场景中具有广泛的应用:

大数据分析:在Hadoop、Spark等大数据处理框架中,数据切片算法用于将大数据集分割成小块,便于后续的分析和处理。

分布式数据库:在分布式数据库系统中,数据切片算法用于将数据分布到不同的节点上,提高数据库的并发处理能力。

数据挖掘:在数据挖掘过程中,数据切片算法可以帮助缩小数据集的范围,提高挖掘效率。

实现数据切片算法的挑战

实现高效的数据切片算法面临以下挑战:

数据分布不均:在数据切片过程中,可能会出现数据分布不均的情况,导致某些处理节点负载过重。

内存限制:在处理大规模数据集时,内存限制可能会成为瓶颈,影响切片算法的效率。

算法复杂度:设计高效的数据切片算法需要考虑算法的复杂度,以确保在处理大规模数据集时保持高效性。

结论

高效数据切片算法是大数据时代数据处理的重要技术之一。通过对数据集进行合理切片,可以提高数据处理效率,降低内存消耗,并支持分布式计算。本文介绍了数据切片算法的原理、设计、应用场景以及实现方法,为读者提供了关于高效数据切片算法的全面了解。

转载请注明来自北京京通茗荟网络科技有限公司,本文标题:《高效数据切片算法:数据切片什么意思 》

蜀ICP备2022005971号-1

蜀ICP备2022005971号-1

还没有评论,来说两句吧...